在过去,如果我们想自动化操作手机,通常需要使用 Appium 或 Airtest 这样的工具,但这要求开发者必须深入了解 APP 的底层元素 ID,比如resource-id或xpath。一旦 APP 更新,ID 变了,脚本就废了。现在有了 AI 大模型,尤其是视觉模型,让 AI 操纵手机做成了可能。推荐几个比较热门的 AI 操纵手机的开源项目,感兴趣的收藏。01MobiAgent:移动智能体框架这个叫 MobiAgent 的开源项目是 IPADS 实验室专为手机交互设计的框架。能让 AI 控制手机自己干活。 比如:帮我在小红书找一下推荐的最畅销的男士牛仔裤,然后在淘宝搜这一款裤子,把淘宝中裤子品牌、名称和价格用微信发给小赵

比如:帮我在小红书找一下推荐的最畅销的男士牛仔裤,然后在淘宝搜这一款裤子,把淘宝中裤子品牌、名称和价格用微信发给小赵

再比如:打开饿了么点一杯蜜雪冰城的柠檬水

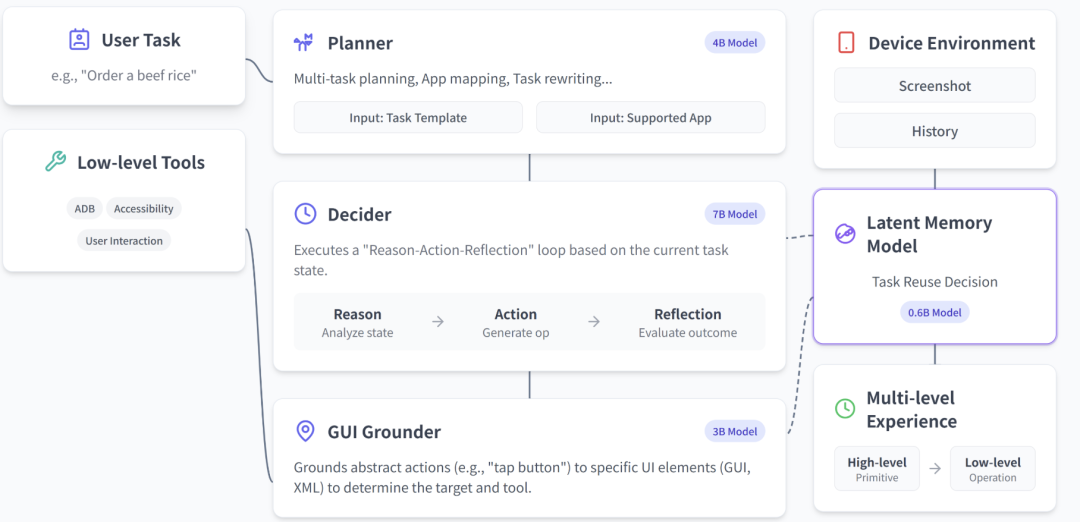

这个智能 Agent 系统,可以把复杂任务分解为三个专业化模块:

Planner负责制定整体计划,Decider判断每一步该点击哪里,Grounder则精准定位屏幕上的具体操作位置。

从原理上讲,MobiAgent 包括三个核心组件:MobiMind 模型家族、AgentRR 加速框架和 MobiFlow 基准测试平台。MobiMind 是智能核心,包含多个不同参数规模的模型。AgentRR 加速框架则对重复任务进行优化,大幅降低二次执行的耗时。比如下面和这个案例,首次执行和后续执行的耗时对比。

而 MobiFlow 基准测试平台,覆盖小红书、高德地图、饿了么、淘宝等 10 + 主流 App,包含简单和困难两个难度等级,为移动智能代理的性能评估提供了标准化场景。

开源地址:https://github.com/IPADS-SAI/MobiAgent

02Mobile-Agent:阿里开源

Mobile-Agent 的开源项目是阿里开源的。

开源地址:https://github.com/X-PLUG/MobileAgent

03Droidrun:手机自动化 Agent 框架

目前在 GitHub 上有 6.2K 的 Star。它的核心理念是将思考交给 AI,将执行交给框架,从而打破了传统自动化脚本对特定 UI 控件的强依赖。 住宿预订:搜索下周旧金山可供两人入住的公寓房源,并提供最便宜的选项。

住宿预订:搜索下周旧金山可供两人入住的公寓房源,并提供最便宜的选项。

开源地址:https://github.com/droidrun/droidrun

04AppAgent:腾讯开源这个开源项目的全称是 “Multimodal Agents as Smartphone Users”,像智能手机用户一样的多模态智能体。它的设计初衷是赋予 AI Agent 像人类用户一样的感知和操作能力。

它通过 ADB(Android Debug Bridge)获取手机屏幕截图,发送给多模态大模型。模型分析截图中的 UI 元素,决定下一步是点击哪个坐标还是滑动屏幕,从而实现真正的视觉交互。

和其它开源项目不同,AppAgent模仿了人类学习新软件的过程:当你给它一个新的 App 时,它可以通过自主探索或者观察人类演示来学习。在这个过程中,它会记录下每个按钮是干什么的,并生成一份使用文档(Knowledge Base)。当需要执行具体任务,它会调用之前生成的文档,精准地执行操作,而不需要每次都重新摸索。

开源地址:https://github.com/TencentQQGYLab/AppAgent

05mobile-use:说句话自动化你的手机

Mobile-Use是一个由 Minitap AI 团队开源的 Python 库。它的核心逻辑是让 AI 模型模拟人类的操作行为。它会截取当前手机屏幕的图像,将截图和用户的指令发送给多模态大模型。模型会分析截图,判断如果要完成这个任务,我现在该点哪里。模型返回具体的坐标或操作指令(点击、滑动、输入),Mobile-Use 将其转换为底层的ADB 命令执行。执行完动作后,再次截图,确认是否进入了下一页,直到任务完成。

开源地址:https://github.com/minitap-ai/mobile-use

06点击下方卡片,关注逛逛 GitHub

© 版权声明

文章版权归作者所有,未经允许请勿转载。