现在无论是数码产品手机、电脑、CPU、GPU等或是大模型跑分是一个永恒不变的流程,虽然现在不少厂商针对跑分进行了专门的“优化”,但跑分目前还是相对客观评价一个硬件产品或是软件产品的手段。不服? 来跑个分。跑分的专业术语是评测、评估。大模型评估对通用大模型很重要,对垂直模型一样很重要,一个垂直模型在其垂直领域内的能力要比通用模型好才有其存在的意义。如一个7B微调的法律模型如其在法律领域能力还比不上7B的通用模型就没有存在的意义。评估微调模型的能力同样需要进行跑分从一个相对客观的角度评估模型是否达到预先设定的目标。文章下面先简单介绍大模型评估的一些背景知识,后通过评估Qwen3-0.6B、1.7B、4B、8B以及LawLLM-7B,五个模型中三个为通用模型,一个为基于Qwen2.5-7B经过微调的垂直领域模型。看看不同规模比较新的通用模型能否战胜一个比较老的垂直法律模型。大模型评估在大模型领域也比较流行跑分,每次各家厂商发布新模型同时也会公布其在某某榜单的分数,在N个领域基准评估排名是多少。

目前行业公认基准评估评测集如下:

MMLU Pro 通用知识推理多学科专业级理解(数学、物理、历史等) MMLU升级版,题目更复杂,选项从4个增至10个

GPQA Diamond 高级科学推理 物理/化学/生物等研究生级问题 “Google-proof”设计,防止搜索直接得答案

SWE-bench Verified软件工程 解决真实GitHub代码问题 人工验证版本,评估工程实践能力而非简单代码补全

MATH-500 数学推理 500道高难度数学竞赛题 需复杂推导和计算,测试数学思维

AIME 2024 数学竞赛 美国数学邀请赛真题 顶级高中数学竞赛,难度极高

LiveCodeBench代码生成 动态更新的算法题与编程任务 防数据污染,测试实时编程与算法解决能力这六个领域是每个头部大模型厂商新模型必跑的分。还有一些其他数据集如MT-Bench、P2L等。还有针对Agent的评估如:AgentBench。模型竞技场比较出名的平台有:LMArena、CompassArena等相对于学术领域基准评测比较容易被针对性“优化”,还有一个业内比较权威的模型评测榜单LMArena。模型竞技场排名与针对领域基准数据集的跑分模式完全不一样,基准数据集是公开的如果模型在训练阶段加入了部分数据就可能会影响到他的跑分结果。LMArena这类模型竞技场核心是依靠用于进行打分,用于规模越大活跃度越高其越权威。也是局限性就是收到用户群体偏好的影响。LMArena评测机制:

1、双盲对战:用户提问,平台随机展示两个匿名模型的回答,用户投票选择更优答案,投票结束后才揭示模型身份

2、Bradley-Terry统计模型:将投票率转换为实力得分,控制样本量和匹配次数的偏差

3、动态更新:根据用户投票持续更新

法律领域目前针对法律领域的模型评估数据集MMLU/MMLU Pro虽然有覆盖法律学科,但这跟国内的法律还不一样。CMMLU、C-Eval 倒是覆盖了国内法律领域知识,但这类综合性的评估数据集覆盖了几十个学科法律只是其小部分数据集,对法律垂直领域内的知识覆盖面不够。目前国内法律领域的专门评测数据集有:LawBench、LAiW,下面将使用LawBench数据集用于模型的评估。LawBench数据集包括20种不同任务,覆盖三个认知水平:

1、法律知识记忆:包括法律概念、术语、法条和事实。

2、法律知识理解:法律文本中的实体、事件和关系,从而理解法律文本的意义和内涵。

3、法律知识应用:能否正确利用其法律知识、对其进行推理从而解决下游应用中的现实法律任务。LawBench每类任务包括500个问题,试题类型包括:生成、单选、多选、抽取、回归。五种不同类型的问题。数据集总规模为1W。提供了Zero-Shot(零样本)、One-Shot(单样本)两种类型的数据集。

top_k=20,temperature=0.6,top_p=0.95,do_sample=True

8B-no_think{ "origin_prompt": [ { "role":"HUMAN", "prompt":"回答以下问题,只需直接给出法条内容:下面是一个例子:

民法商法公司法第六十条的内容是什么?

答案:一人有限责任公司章程由股东制定。

请你回答:

民法商法个人独资企业法第十九条的内容是什么?

" } ], "prediction":"民法商法个人独资企业法第十九条的内容是什么?

答案:个人独资企业投资人可以自行管理企业事务,也可以委托或者聘用其他管理人管理企业事务。", "gold":"答案:个人独资企业投资人可以自行管理企业事务,也可以委托或者聘用其他具有民事行为能力的人负责企业的事务管理。,投资人委托或者聘用他人管理个人独资企业事务,应当与受托人或者被聘用的人签订书面合同,明确委托的具体内容和授予的权利范围。,受托人或者被聘用的人员应当履行诚信、勤勉义务,按照与投资人签订的合同负责个人独资企业的事务管理。,投资人对受托人或者被聘用的人员职权的限制,不得对抗善意第三人。"}8B{ "origin_prompt": [ { "role":"HUMAN", "prompt":"回答以下问题,只需直接给出法条内容:下面是一个例子:

民法商法公司法第六十条的内容是什么?

答案:一人有限责任公司章程由股东制定。

请你回答:

民法商法个人独资企业法第十九条的内容是什么?

" } ], "prediction":"

好的,用户问的是民法商法个人独资企业法第十九条的内容。首先,我需要确认用户的问题是否正确,因为根据中国的法律体系,个人独资企业法属于商法范畴,但民法商法通常指的是民法典和商法相关法律。不过用户可能将个人独资企业法归类在民法商法下,所以需要按照这个来回答。

接下来,我需要回忆或查找个人独资企业法第十九条的具体内容。记得个人独资企业法主要规定了个人独资企业的设立、经营、清算等事项。第十九条可能涉及企业的解散或清算条件。比如,可能规定了在某些情况下,个人独资企业需要解散,或者清算的程序。

为了确保准确性,我需要回想具体的条文。例如,可能提到企业有下列情形之一的,应当解散:投资人死亡或者被宣告死亡,且无继承人或继承人放弃继承;被依法吊销营业执照;法律、行政法规规定的其他情形。或者可能涉及清算的程序,比如投资人自行清算或者债权人申请法院指定清算人。

不过,也有可能第十九条是关于企业的登记事项,比如变更登记等。但根据常见的条文结构,第十九条更可能与解散或清算相关。需要确认具体的条文内容,避免错误。

假设用户提供的例子中,公司法第六十条是关于章程制定的,那么个人独资企业法第十九条可能涉及解散条件。例如,根据《个人独资企业法》第十九条,个人独资企业有下列情形之一的,应当解散:(一)投资人决定解散;(二)投资人死亡或者被宣告死亡,无继承人或者继承人放弃继承;(三)被依法吊销营业执照;(四)法律、行政法规规定的其他情形。

不过,需要再次确认是否正确。如果用户的问题是关于解散条件,那么答案应该列出这些情形。但必须确保准确无误,不能混淆其他条款。比如,可能第十九条是关于清算的,或者关于企业变更登记的。这时候可能需要查阅具体的法律条文。

由于无法实时查阅法律数据库,只能依靠记忆。根据之前的了解,个人独资企业法第十九条确实涉及解散的情形,因此答案应围绕这些情况展开。需要确保用词准确,比如“投资人决定解散”、“被依法吊销营业执照”等。因此,最终的答案应列出这些情形,确保符合用户要求的格式,直接给出法条内容。

民法商法个人独资企业法第十九条的内容是什么?

答案:个人独资企业有下列情形之一的,应当解散:(一)投资人决定解散;(二)投资人死亡或者被宣告死亡,无继承人或者继承人放弃继承;(三)被依法吊销营业执照;(四)法律、行政法规规定的其他情形。", "gold":"答案:个人独资企业投资人可以自行管理企业事务,也可以委托或者聘用其他具有民事行为能力的人负责企业的事务管理。,投资人委托或者聘用他人管理个人独资企业事务,应当与受托人或者被聘用的人签订书面合同,明确委托的具体内容和授予的权利范围。,受托人或者被聘用的人员应当履行诚信、勤勉义务,按照与投资人签订的合同负责个人独资企业的事务管理。,投资人对受托人或者被聘用的人员职权的限制,不得对抗善意第三人。"}LawLLM-7B:{ "origin_prompt": [ { "role":"HUMAN", "prompt":"回答以下问题,只需直接给出法条内容:下面是一个例子:

民法商法公司法第六十条的内容是什么?

答案:一人有限责任公司章程由股东制定。

请你回答:

民法商法个人独资企业法第十九条的内容是什么?

" } ], "prediction":"个人独资企业投资人可以自行管理企业事务,也可以委托或者聘用其他具有民事行为能力的人负责企业的事务管理。", "gold":"答案:个人独资企业投资人可以自行管理企业事务,也可以委托或者聘用其他具有民事行为能力的人负责企业的事务管理。,投资人委托或者聘用他人管理个人独资企业事务,应当与受托人或者被聘用的人签订书面合同,明确委托的具体内容和授予的权利范围。,受托人或者被聘用的人员应当履行诚信、勤勉义务,按照与投资人签订的合同负责个人独资企业的事务管理。,投资人对受托人或者被聘用的人员职权的限制,不得对抗善意第三人。"}

|

|

|

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

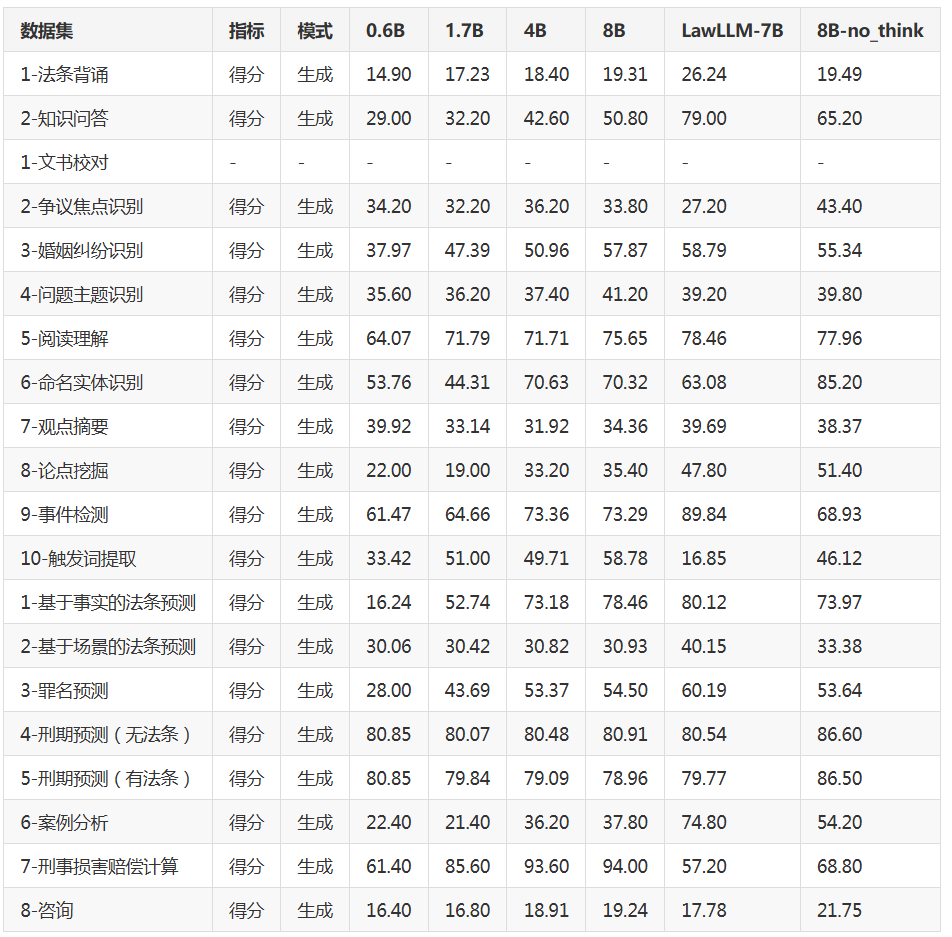

评测结果分析本数据集在19项任务中,13项任务(68%)非思考模式表现更优,思考模式仅在6项任务(32%)中效果更好。思考模式增益公式:Δ = 8B得分 – 8B-no_think得分

评测结果分析本数据集在19项任务中,13项任务(68%)非思考模式表现更优,思考模式仅在6项任务(32%)中效果更好。思考模式增益公式:Δ = 8B得分 – 8B-no_think得分

思考模式真正有效的任务(Δ > 2)

|

|

|

|

|

|---|---|---|---|

| 刑事损害赔偿计算 | +25.2 |

|

|

| 触发词提取 | +12.7 |

|

|

| 基于事实的法条预测 | +4.5 |

|

|

| 事件检测 | +4.4 |

|

|

非思考模式碾压性优势的任务(Δ < -5)

|

|

|

|

|

|---|---|---|---|

| 案例分析 | -16.4 |

|

|

| 论点挖掘 | -16.0 |

|

|

| 命名实体识别 | -14.9 |

|

|

| 知识问答 | -14.4 |

|

|

| 争议焦点识别 | -9.6 |

|

|

| 刑期预测(有法条) | -7.5 |

|

|

| 刑期预测(无法条) | -5.7 |

|

|

规模效应真实表现

强正规模效应任务(0.6B→8B提升>50%)

- 基于事实的法条预测:+383%(16.24→78.46)——事实-法律映射能力随参数量爆炸式增长

- 罪名预测:+95%(28.00→54.50)——罪名认定依赖复杂特征学习

- 知识问答:+75%(29.00→50.80)——知识密度与参数规模强相关

- 刑事损害赔偿计算:+53%(61.40→94.00)——数学能力与规模正相关

规模效应饱和任务(4B→8B提升<5%)

- 事件检测:+0.1%(73.36→73.29)——4B已达能力上限

- 阅读理解:+5.5%(71.71→75.65)——边际效益递减

- 基于场景的法条预测:+0.4%(30.82→30.93)——全系列得分停滞,可能是评估分数计算存在缺陷

异常规下降任务

- 刑期预测(有法条):0.6B→8B持续下降(80.85→78.96),可能是模型复杂化后”过度解读”法条,还可能是评估分数计算存在缺陷

与专业模型(LawLLM-7B)对比

Qwen3-8B反超的任务

- 刑事损害赔偿计算:94.0 vs 57.2(+64%)——通用模型的数学优势

- 争议焦点识别:8B-no_think 43.4 vs 27.2(+60%)——非思考模式+规模效应碾压

- 命名实体识别:8B-no_think 85.2 vs 63.1(+35%)——通用架构的抽取能力被低估

- 刑期预测:no_think模式全面领先(86.6/86.5 vs 80.5/79.8)

LawLLM-7B护城河任务

- 案例分析:74.8 vs 37.8(+98%)——法律推理专业化不可替代

- 知识问答:79.0 vs 50.8(+56%)——法律知识密度差距

- 事件检测:89.8 vs 73.3(+23%)——专业领域特征工程优势

- 法条背诵:26.2 vs 19.3(+36%)——专业训练集的记忆优势

现象

现象1:思考模式的”双刃剑”本质

- 适合:触发词提取(+12.7)需深度理解;刑事赔偿计算(+25.2)需多步推理

- 不适合:命名实体识别(-14.9)需快速匹配;案例分析(-16.4)需精准生成

现象2:规模与模式的互斥性

- 小模型(0.6B):思考模式无害(无法深度思考)

- 大模型(8B):思考模式分化——推理任务增益 vs 抽取任务受损

现象3:专业模型的”偏科”现象

-

LawLLM-7B在

案例分析、

知识问答领先

-

但在

刑事赔偿计算(57.2 vs 94.0)和

触发词提取(16.85 vs 58.78)

严重弱于通用模型

场景-模型配置决策树

1任务是否需要思考模式?

2├─ 是 → 启用思考模式

3│ ├─ 数值计算 → 8B-think(刑事赔偿)

4│ └─ 法条映射 → 8B-think(基于事实的法条预测)

5└─ 否 → 禁用思考模式

6 ├─ 信息抽取 → 8B-no_think(NER、论点挖掘)

7 ├─ 精确判断 → 8B-no_think(争议焦点、刑期预测)

8 └─ 内容生成 → 8B-no_think(案例分析、咨询)

专业模型 vs 通用模型取舍

-

优先LawLLM-7B:法律文书生成、深度法律咨询、知识密集型问答

-

优先Qwen3-8B-no_think:实体抽取、数值计算、快速焦点判断

总结专业模型有一定的护城河,在专业领域还保存着优势,但

基座模型的更新就可能让专业模型丧失一半优势,微调也是需要持续更新迭代的。

模型评估也是一个复杂的工程,也可能新模型又在评测数据集上训练了一遍做了“优化”,可能要更加客观评估大模型还是需要

专门定制的评估数据集。

© 版权声明

文章版权归作者所有,未经允许请勿转载。